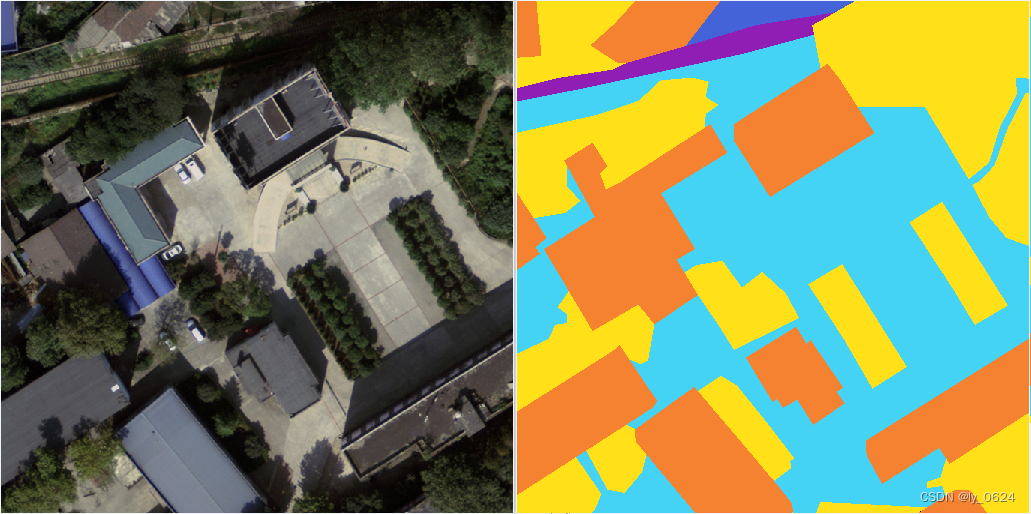

![图片[1] - AI科研 编程 读书笔记 - 【人工智能】FarmSeg_VLM:一种考虑视觉-语言对齐的农田遥感图像分割方法 - AI科研 编程 读书笔记 - 小竹の笔记本](https://img.smallbamboo.cn/i/2025/07/13/6873659c066d7.png)

期刊:Isprs Journal Of Photogrammetry And Remote Sensing;接受日期:2025年5月7日;作者团队来自中南大学地球科学与信息物理学院。

论文链接:https://www.sciencedirect.com/science/article/abs/pii/S0924271625001911

一、动机

1.时空异质性挑战

传统分割模型(如 CNN/FCN 系列)仅关注局部视觉特征,难以应对农田遥感影像中由于季节、气候、人为活动等引起的表观变化,导致模型在跨区域、跨时域分割精度下降。

2.图文对齐粒度不足

现有 VLM(如 CLIP、LISA 等)受限于文本长度与注意力机制,对农田遥感影像中多种地物——耕地、林地、水体、建筑等—碎片化、分散式分布的空间语义难以精细对齐,注意力热图表现出对农田区域聚焦不足、误聚焦其他地物的现象。

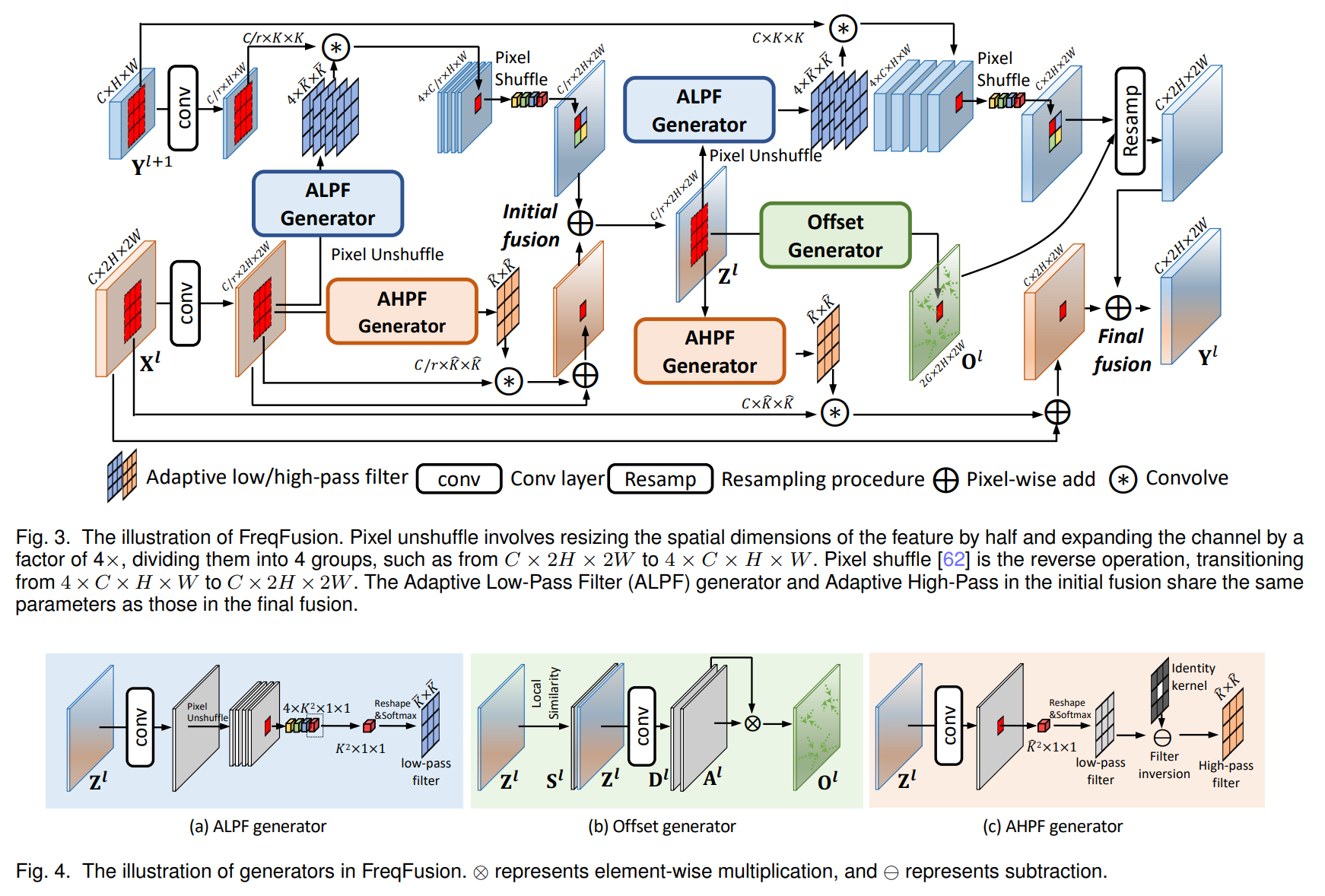

二、核心方法

FarmSeg_VLM 主要由两个关键模块组成,分别是图文空间对齐策略(ITSA_MLBP)和图文对齐适配器(ITAA),同时还引入了提示桥接机制和联合损失设计来实现精细的遥感分割。

![图片[2] - AI科研 编程 读书笔记 - 【人工智能】FarmSeg_VLM:一种考虑视觉-语言对齐的农田遥感图像分割方法 - AI科研 编程 读书笔记 - 小竹の笔记本](https://img.smallbamboo.cn/i/2025/07/13/68736902a7761.png)

1.图文空间对齐策略(ITSA_MLBP)

该策略的核心目的是提升模型对图像中多种地物的语义理解与空间识别能力。方法上,在训练时使用图像、文本和对应的掩模三元组进行联合学习。所有图像都会搭配耕地的文本描述,同时从其余地物(如林地、水体、建筑等)中随机选取两类地物文本加入训练,使模型能在语义上区分耕地与背景地物。通过这种方式,模型不仅能学会定位耕地,还能理解图像中其他语义区域,从而提高跨区域泛化能力。

2.图文对齐适配器(ITAA)

该模块主要作用是实现稠密视觉提示和稀疏语言提示之间的特征融合。首先使用 SAM(Segment Anything Model)提取图像的嵌入特征和掩模,通过卷积处理后作为稠密提示;同时,使用多模态大语言模型(如 LLaVA)根据文本描述输出稀疏提示。然后通过一个跨注意力模块将这两种提示对齐融合,得到高语义一致性的特征向量。最后通过全连接层(MLP)调整后,与原图像特征共同输入解码器,生成最终的像素级分割结果。

3.提示桥接机制(Embedding as Mask)

为了更好地桥接文本生成模型与分割任务之间的语义落差,作者在多模态语言模型中引入了一个特殊的符号 <SEG>,代表“我想要你分割图中的耕地区域”。模型在文本生成时,当输出该符号时,其对应的内部嵌入就被用作 SAM 的提示输入,实现从文本到视觉分割的闭环。这种做法保证了语言信息可以直接参与图像分割的提示生成,使得图文协同更加紧密。

4.联合损失设计

为了同时优化语言生成和图像分割两个目标,作者引入了一种联合训练方式,结合了文本生成损失(例如语言预测的交叉熵)和分割损失(例如二值交叉熵和 Dice 损失)。在训练过程中,两个损失按照一定比例加权求和,从而兼顾语言与视觉两个通道的学习效果,提高整体系统性能。

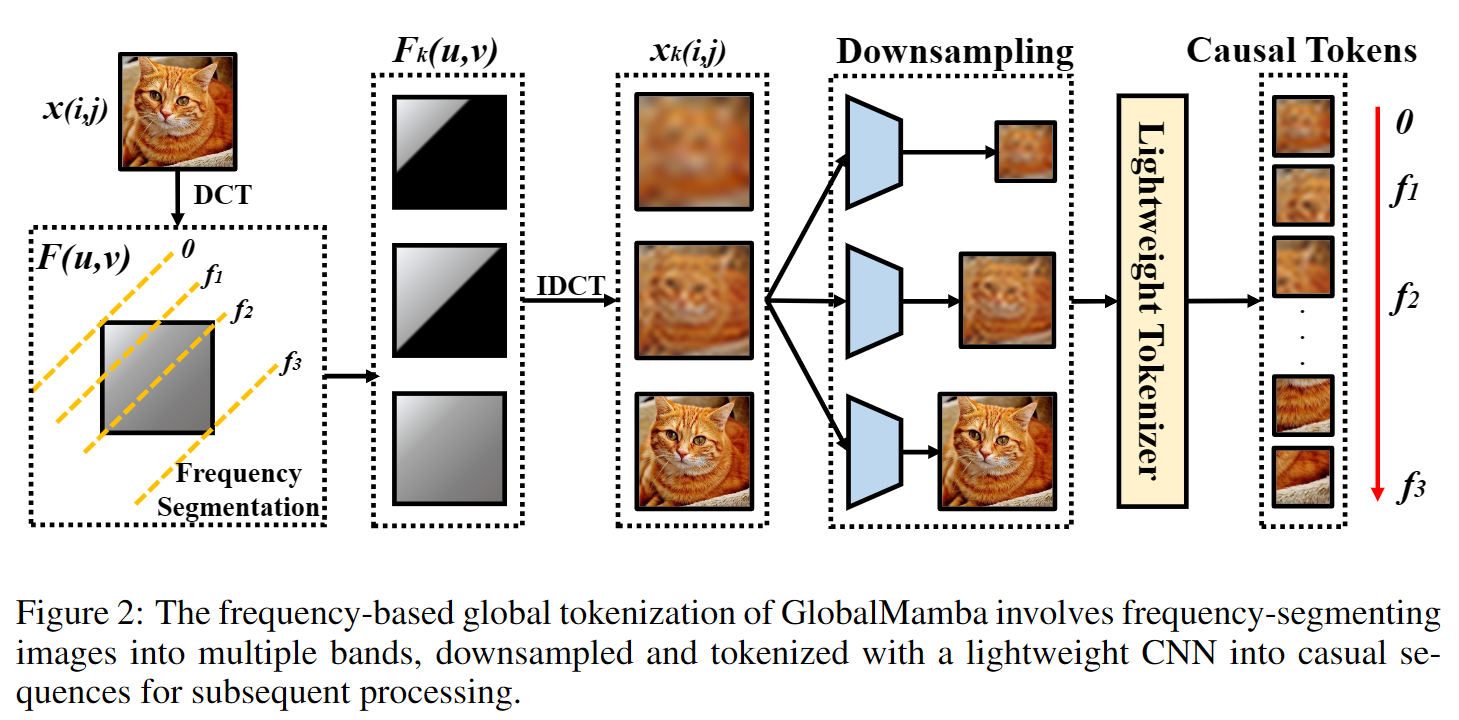

![图片[3] - AI科研 编程 读书笔记 - 【人工智能】FarmSeg_VLM:一种考虑视觉-语言对齐的农田遥感图像分割方法 - AI科研 编程 读书笔记 - 小竹の笔记本](https://img.smallbamboo.cn/i/2025/07/13/687369220fce6.png)

三、实验结果

- 消融实验(基线:无 ITSA_MLBP/ITAA)基线 ACC 88.79%、mIoU 78.05%;仅 ITSA_MLBP:89.95%/79.86%;仅 ITAA:89.47%/79.70%;二者结合:90.38%/80.00%。

- 区域内对比(广东/河南/湖南/云南)对比包括 Deeplabv3+、Segformer、U-Net、CMTFNet、MCCANet、DBBANet 及 DenseClip、PixeLLM、LISA 等,FarmSeg_VLM 在所有指标上均领先,广东省 mIoU 达 80.35%,相比第二名 LISA 提升约1.4%;河南省 mIoU 89.53%,提升约2.6%。

- 跨时空域泛化测试于 LoveDA、FGFD、DeepGlobe2018、Huawei Ascend Cup AI、2020CCF_BDCI 等五个与 FIT 数据集时空分布完全不同的数据集。FarmSeg_VLM 在 Acc 和 mIoU 上均优于传统和其他 VLM 模型,尤其在 LoveDA 和 FGFD 上优势显著,验证了方法的泛化能力。

- 稳健性(目标缺失场景)在 LoveDA 中选取 969 张无耕地图像测试,模型在非耕地集上仍可实现 Acc 96.27%、FWIoU 96.26%,混入 FIT 测试集后整体精度跌幅有限并略有回升,证明了较强的抗干扰能力与稳定性。

- 大规模制图应用在安徽(地形复杂、田块碎片化)与河北(规模化平原)两省制图实验中,模型均能细致捕捉地块边界与形状,在河北表现尤为优越,仅在少数水田交界处出现轻微模糊,展示了良好的工程化可用性。

四、对比算法

主流通用分割:Deeplabv3+、Segformer、U-Net。

遥感专用模型:CMTFNet、MCCANet、DBBANet。

视觉–语言模型:DenseClip、PixeLLM、LISA。

FarmSeg_VLM 在对齐粒度有专门设计,故在农田遥感场景下全面超越上述方法。

五、数据集

FIT:空间分辨率 0.5 m,涵盖湖南、广东、安徽、云南 7269 张图文样本,切片大小 512 × 512。

跨域测试集如下

LoveDA (2021, 0.3 m, 1024×1024, 南京/常州/武汉,7 类,5987 张)

FGFD (2024, 0.3 m, 512×512,全国六大区域,2 类,2606 张)

DeepGlobe2018 (2018, 0.5 m, 2448×2448,泰国/印尼/印度,7 类,1146 张)

Huawei Ascend Cup AI (2020, 0.1–4 m, 256×256,8 类,100 000 张)

2020CCF_BDCI (2020, 2 m, 256×256,7 类,30 000 张)

(标签统一为“耕地/背景”以保证可比性)。

六、改进空间

- 模糊描述处理:对缺少清晰边界的场景,当前语言提示仍可能导致过度/欠分割,可在提示工程中引入更细粒度或层次化文本描述。

- 小样本泛化:对训练集中少见或无对应语言描述的地物(如工业荒地、高架道路),模型易产生误判,未来可通过负样本扩充或增强自监督对齐提升鲁棒性。

- 对齐机制优化:在高维跨模态对齐时,跨注意力效率与效果尚有提升空间,后续可探索更高效的匹配机制或多尺度提示融合策略。

- 多模态增强:结合多光谱/高光谱信息或时序数据,丰富视觉先验,进一步缓解单时相可见光图像的歧义。

2. 论文总结类文章中涉及的图表、数据等素材,版权归原出版商及论文作者所有,仅为学术交流目的引用;若相关权利人认为存在侵权,请联系本网站删除,联系方式:i@smallbamboo.cn。

3. 违反上述声明者,将依法追究其相关法律责任。

- 最新

- 最热

只看作者