![图片[1] - AI科研 编程 读书笔记 - 【人工智能】OverLoCK: 一种先概览后细察且具有上下文混合动态内核的卷积神经网络 - AI科研 编程 读书笔记 - 小竹の笔记本](https://img.smallbamboo.cn/i/2025/04/03/67ee5257d9eb3.png)

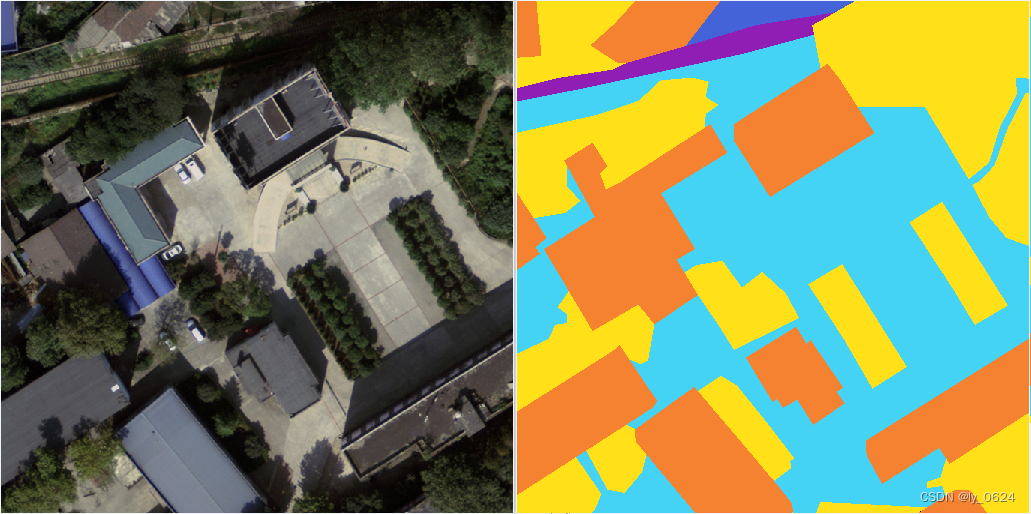

动机(Motivation)

- 生物启发:人类视觉系统通过“先概览后细查”的机制快速定位物体,但传统ConvNet采用金字塔结构逐步下采样,缺乏这种自上而下的注意力机制。

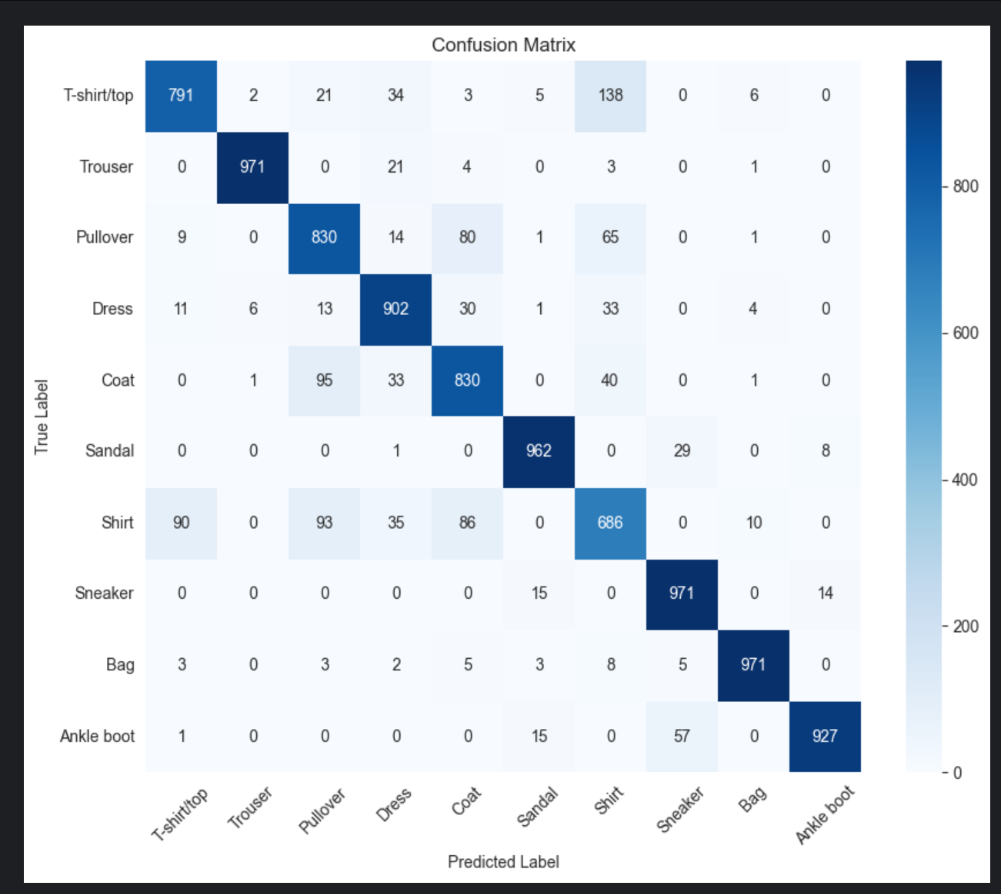

- 现有问题:传统ConvNet的中间层缺乏全局语义引导,导致深层特征难以准确定位物体(如图2所示,Swin-T等模型在深层阶段激活图定位模糊)。

- 动态卷积的局限性:现有动态卷积(如大核卷积、可变形卷积)无法同时建模长距离依赖和保持局部归纳偏置。

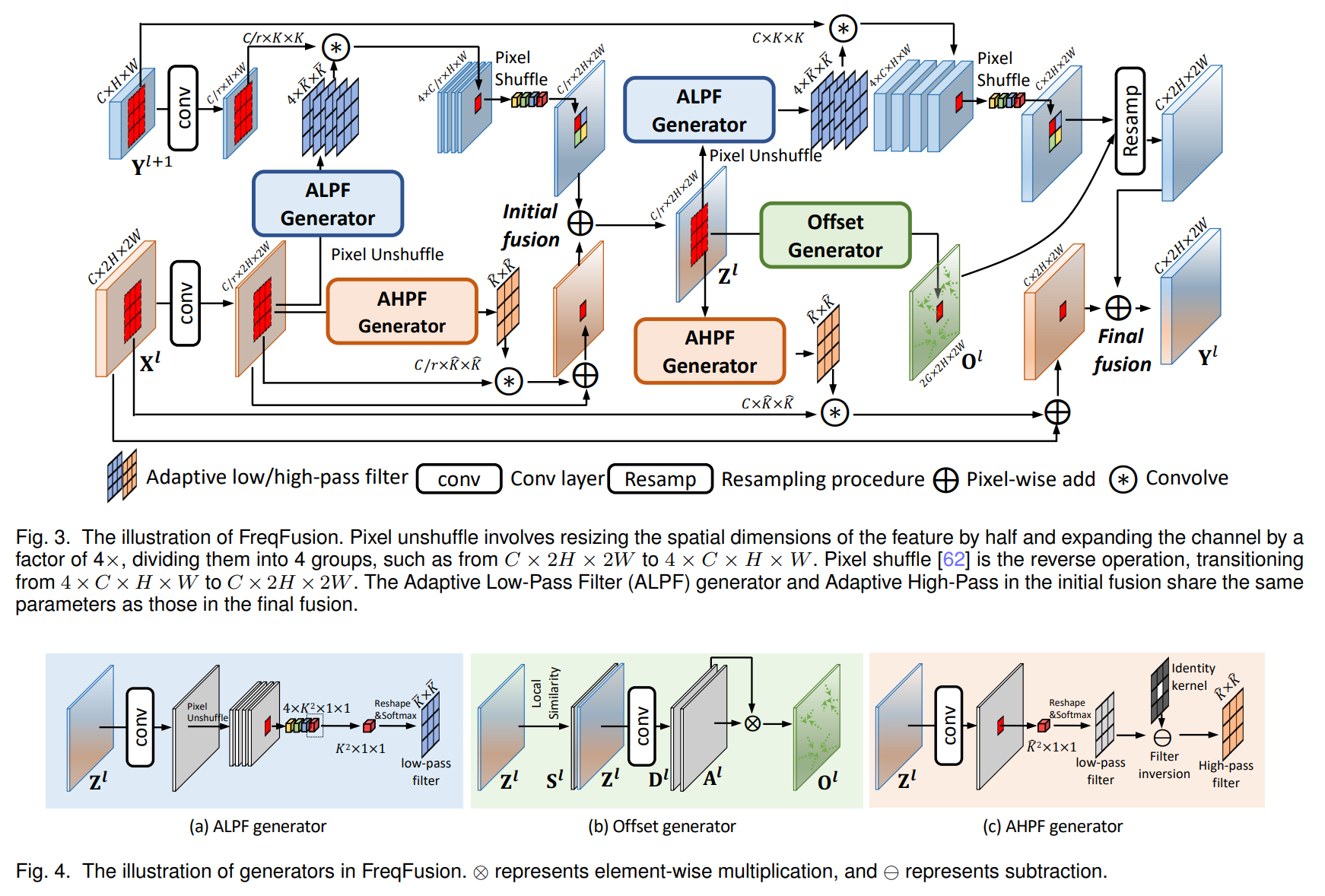

核心方法(Core Method)

- 深度阶段分解策略(DDS)

- Base-Net:编码低/中层特征(输入图像下采样至H/16 x H/16)。

- Overview-Net:轻量级网络生成粗略的全局上下文(“概览”),输出作为上下文先验(Context Prior)。

- Focus-Net:在上下文先验引导下细化特征(“细查”),通过ContMix动态卷积融合全局信息。

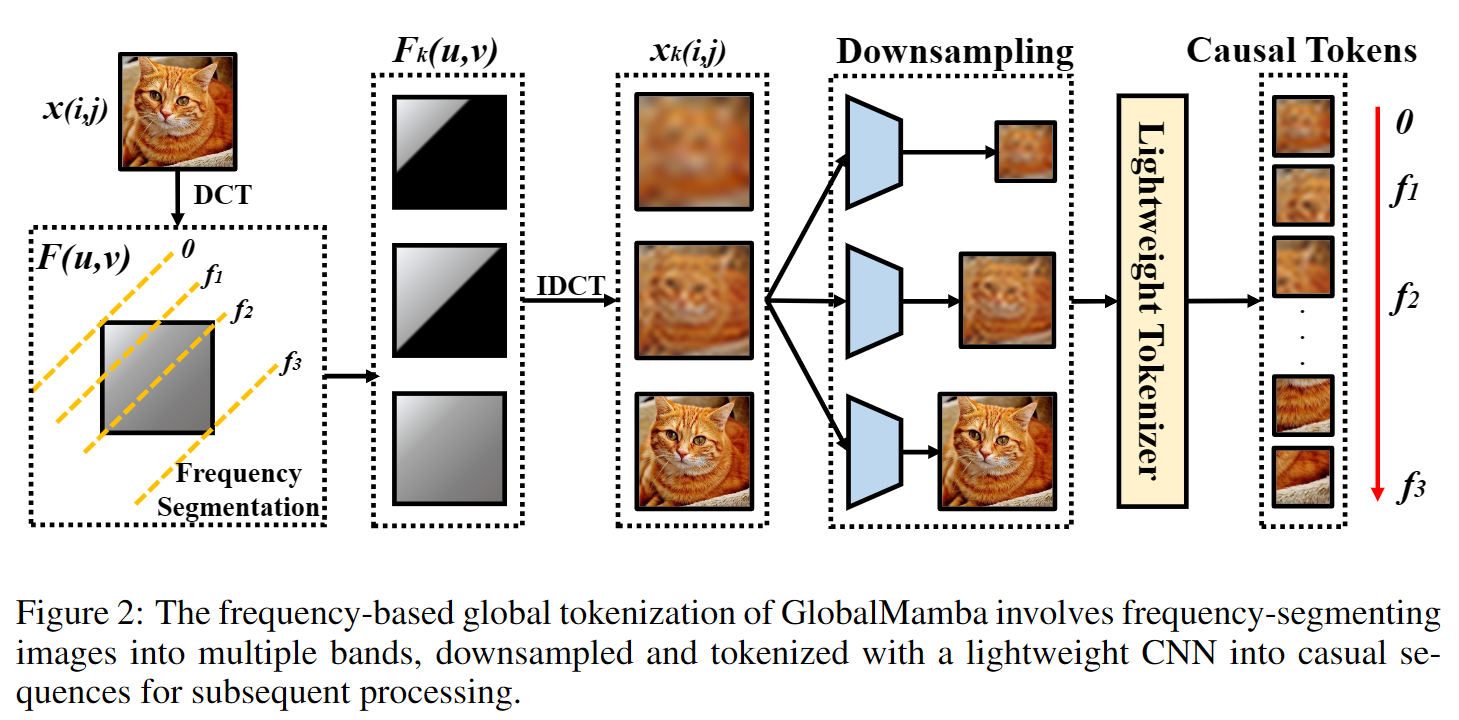

- 上下文混合动态卷积(ContMix)

- 动态核生成:通过计算输入特征与全局上下文区域的亲和力,生成空间变化的动态卷积核。

- 混合全局与局部:大核(如17×17)建模长距离依赖,小核(如5×5)保留局部细节,避免可变形卷积的归纳偏置损失。

- 动态上下文流

- 特征级引导:Overview-Net的上下文先验与Base-Net特征拼接后输入Focus-Net。

- 权重级引导:上下文先验用于生成动态卷积核权重,并在网络前向传播中更新。

![图片[2] - AI科研 编程 读书笔记 - 【人工智能】OverLoCK: 一种先概览后细察且具有上下文混合动态内核的卷积神经网络 - AI科研 编程 读书笔记 - 小竹の笔记本](https://img.smallbamboo.cn/i/2025/04/03/67ee52ba284af.png)

![图片[3] - AI科研 编程 读书笔记 - 【人工智能】OverLoCK: 一种先概览后细察且具有上下文混合动态内核的卷积神经网络 - AI科研 编程 读书笔记 - 小竹の笔记本](https://img.smallbamboo.cn/i/2025/04/03/67ee52db4d495.png)

![图片[4] - AI科研 编程 读书笔记 - 【人工智能】OverLoCK: 一种先概览后细察且具有上下文混合动态内核的卷积神经网络 - AI科研 编程 读书笔记 - 小竹の笔记本](https://img.smallbamboo.cn/i/2025/04/03/67ee531bda682.png)

![图片[5] - AI科研 编程 读书笔记 - 【人工智能】OverLoCK: 一种先概览后细察且具有上下文混合动态内核的卷积神经网络 - AI科研 编程 读书笔记 - 小竹の笔记本](https://img.smallbamboo.cn/i/2025/04/03/67ee52f7cc139.png)

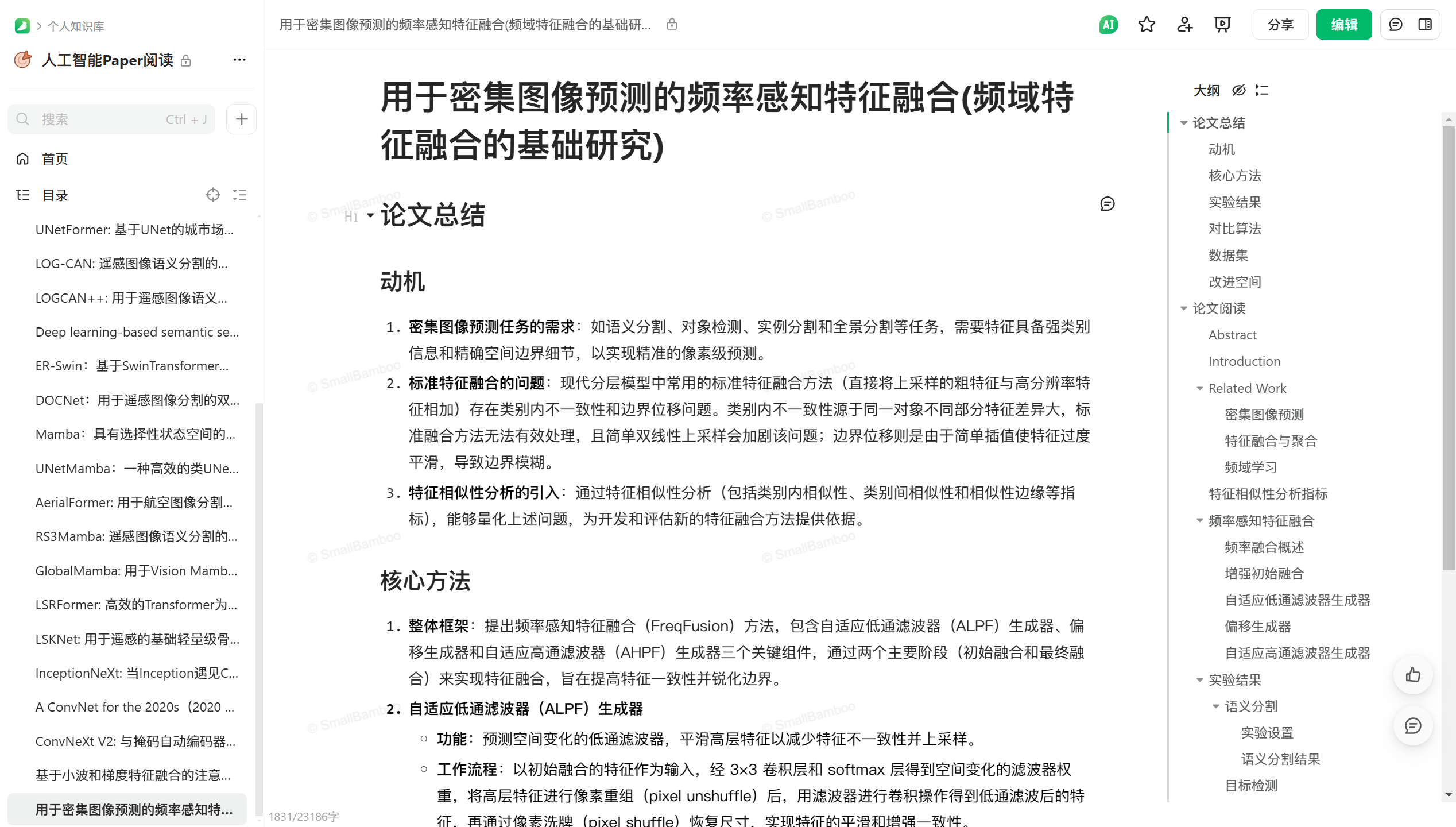

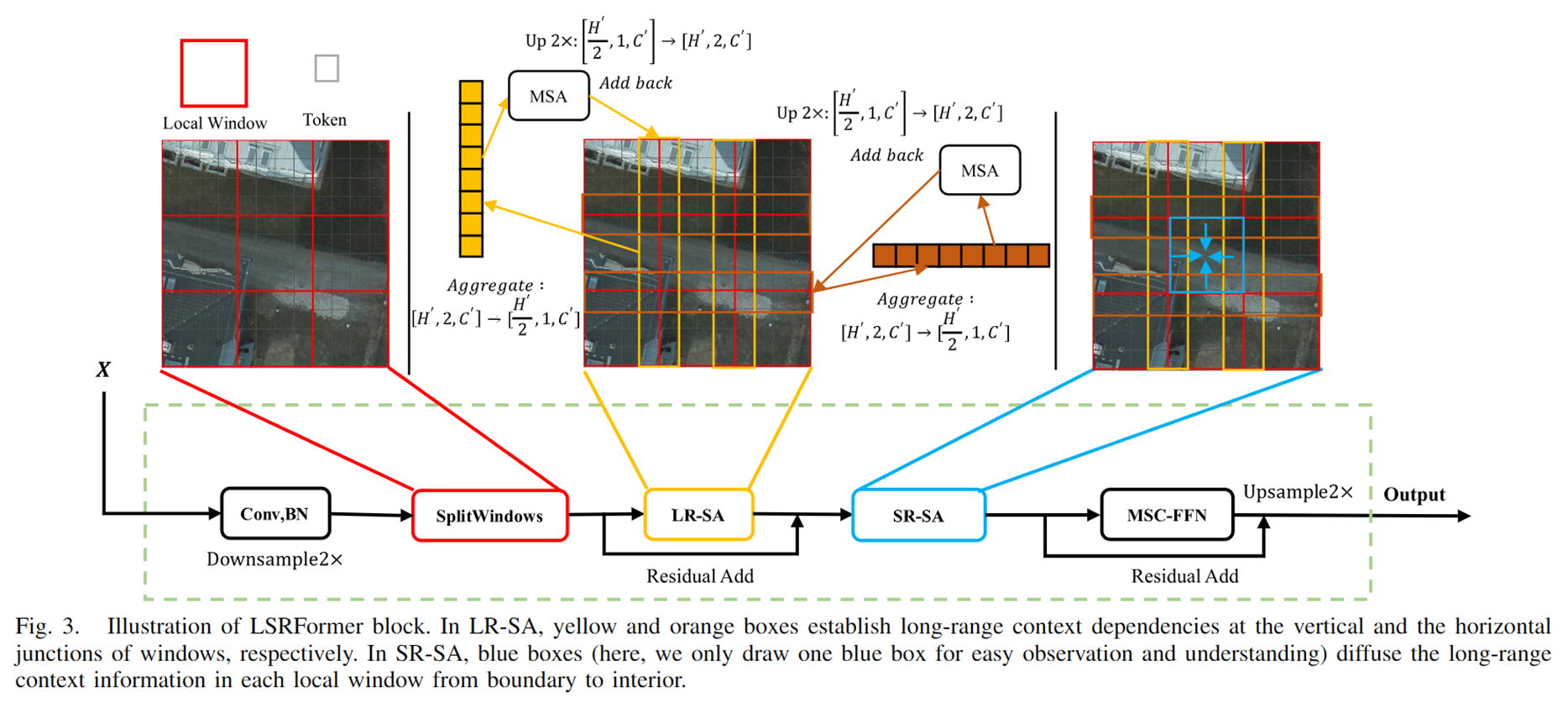

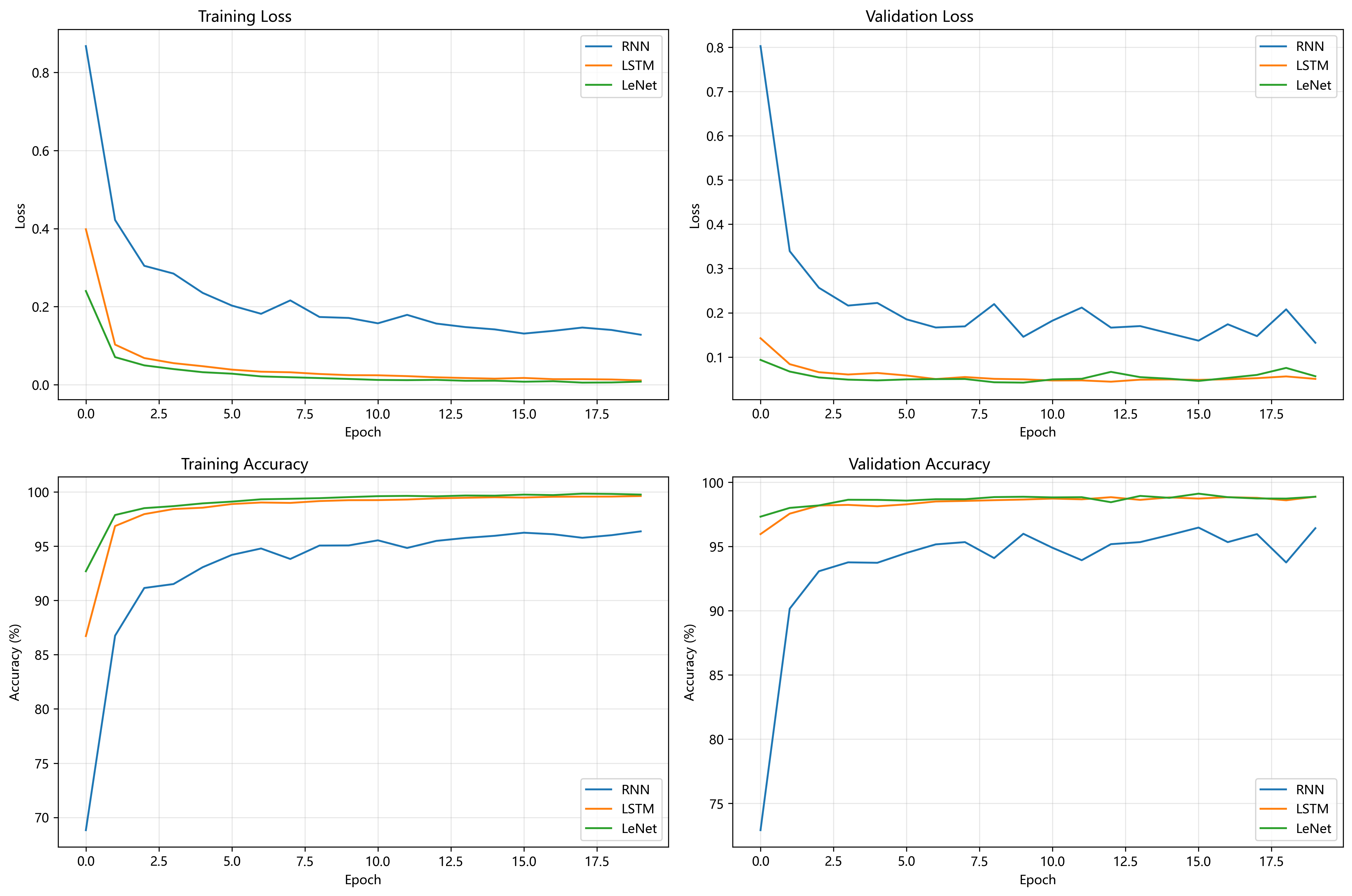

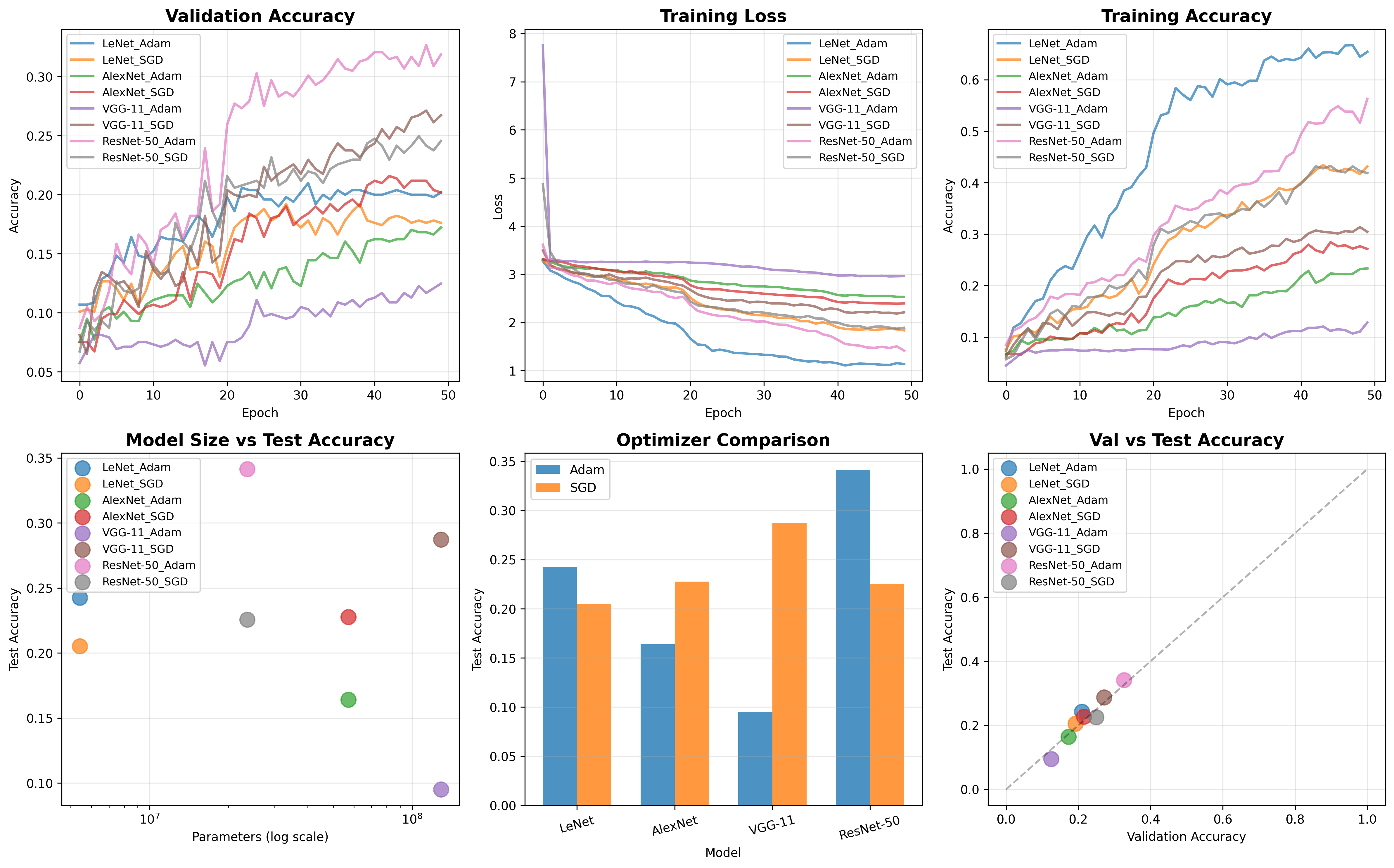

实验结果(Experimental Results)

- ImageNet-1K分类

- OverLoCK-T:84.2% Top-1准确率,FLOPs仅5.5G,显著优于ConvNeXt-T(82.1%)、VMamba-T(82.6%)。

- 模型扩展:OverLoCK-B达到85.1% Top-1,超越MaxViT-B(84.9%)和InternImage-B(84.9%)。

- 下游任务

- 目标检测(COCO):OverLoCK-S在Mask R-CNN框架下APb达49.4%,优于MogaNet-B(48.5%)和VMamba-S(48.7%)。

- 语义分割(ADE20K):OverLoCK-T的mIoU为50.3%,优于UniRepLKNet-T(48.6%)和MogaNet-S(49.2%)。

- 效率对比

- OverLoCK-T吞吐量(810 imgs/s)显著高于ConvNeXt-T(1507 imgs/s),同时保持更高准确率。

对比算法(Baselines)

- ConvNet系列:ConvNeXt、RepLKNet、MogaNet、InternImage。

- Transformer系列:Swin、PVTv2、BiFormer、MaxViT。

- Mamba系列:VMamba。

- 混合模型:UniFormer、HorNet。

数据集(Datasets)

- ImageNet-1K:分类任务预训练。

- COCO:目标检测与实例分割。

- ADE20K:语义分割。

![图片[6] - AI科研 编程 读书笔记 - 【人工智能】OverLoCK: 一种先概览后细察且具有上下文混合动态内核的卷积神经网络 - AI科研 编程 读书笔记 - 小竹の笔记本](https://img.smallbamboo.cn/i/2025/04/03/67ee535615dbd.png)

![图片[7] - AI科研 编程 读书笔记 - 【人工智能】OverLoCK: 一种先概览后细察且具有上下文混合动态内核的卷积神经网络 - AI科研 编程 读书笔记 - 小竹の笔记本](https://img.smallbamboo.cn/i/2025/04/03/67ee536d1605e.png)

![图片[8] - AI科研 编程 读书笔记 - 【人工智能】OverLoCK: 一种先概览后细察且具有上下文混合动态内核的卷积神经网络 - AI科研 编程 读书笔记 - 小竹の笔记本](https://img.smallbamboo.cn/i/2025/04/03/67ee53c4c58ed.png)

改进空间(Future Work)

- 动态卷积优化:进一步降低ContMix的计算复杂度,探索更高效的全局上下文建模方式。

- 多尺度扩展:在更高分辨率输入(如384×384)下优化模型,提升长距离建模能力。

- 跨任务泛化:验证OverLoCK在视频理解、点云处理等任务中的表现。

- 模型轻量化:针对移动端设计更紧凑的变体(如减少Overview-Net的参数量)。

关键贡献

- 首个纯ConvNet架构:通过DDS和ContMix实现生物启发的自上而下注意力机制。

- 动态卷积创新:ContMix在保留局部归纳偏置的同时建模全局依赖,优于传统动态卷积。

- 性能突破:在分类、检测、分割任务上全面超越ConvNeXt、Transformer和Mamba模型。

© 版权声明

1. 除特殊说明外,本网站所有原创文章的版权归作者所有,未经授权,禁止以任何形式(包括但不限于转载、摘编、复制、镜像等)发布至任何平台。

2. 论文总结类文章中涉及的图表、数据等素材,版权归原出版商及论文作者所有,仅为学术交流目的引用;若相关权利人认为存在侵权,请联系本网站删除,联系方式:i@smallbamboo.cn。

3. 违反上述声明者,将依法追究其相关法律责任。

2. 论文总结类文章中涉及的图表、数据等素材,版权归原出版商及论文作者所有,仅为学术交流目的引用;若相关权利人认为存在侵权,请联系本网站删除,联系方式:i@smallbamboo.cn。

3. 违反上述声明者,将依法追究其相关法律责任。

THE END

暂无评论内容